دبیرکل مجمع جهانی تقریب مذاهب اسلامی در سخنرانی خود در مجمع بین المللی فقه اسلامی قطر با تأکید بر ضرورت تحلیل ساختاری آسیب های هوش مصنوعی خواستار محکومیت کاربردهای نظامی این فناوری توسط رژیم صهیونیستی شد. وی با طبقه بندی چالش های هوش مصنوعی در ابعاد حقوقی امنیتی فنی اقتصادی و اجتماعی بر لزوم بررسی تهدیدات فلسفی و آینده پژوهانه آن از جمله «فراهوش مصنوعی» و سلاح های خودمختار تأکید کرد.

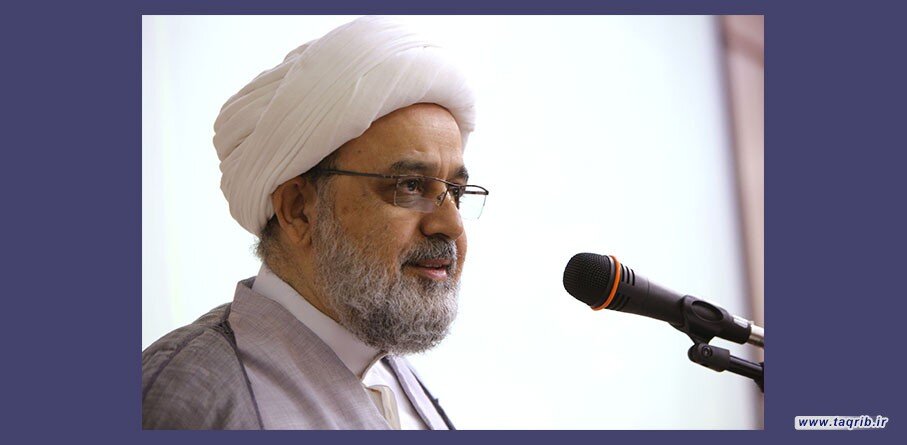

به گزارش مجله لوکس به نقل از روابط عمومی مجمع جهانی تقریب مذاهب اسلامی حجت لاسلام والمسلمین دکتر حمید شهریاری دبیرکل مجمع که به منظور شرکت در بیست و ششمین مجمع فقه اسلامی به قطر سفر کرده است با بیان مطالب و ملاحظاتی درباره ی سخنرانی های حاضران در خصوص احکام هوش مصنوعی و ضوابط و اخلاقیات آن با تاکید بر ضرورت طبقه بندی ساختاری در تحلیل آسیب های هوش مصنوعی گفت: فهرست آسیب های هوش مصنوعی نیازمند چارچوبی منطقی و ساختاری است که ابعاد فنی اخلاقی اجتماعی اقتصادی و اعتقادی را دربر گیرد. بر این اساس پیشنهاد می شود این آسیب ها در پنج سطح بُعد حقوقی ـ فقهی بُعد امنیتی ـ سیاسی بُعد فنی ـ سیستمی بُعد اقتصادی و بُعد اجتماعی ـ فرهنگی طبقه بندی شوند.

وی افزود: صرفِ ذکر آسیب ها گرچه ضروری است اما کافی نیست؛ بلکه باید به صورت گسترده تری تهدیدات وجودی و فلسفی به ویژه در سطح آینده پژوهانه بیان گردد و با شواهد واقعی و مصادیق عینی مستند شود. از جمله این تهدیدات می توان به سناریوهای مربوط به فراهوش مصنوعی (Superintelligence) فقدان امکان کنترل بلندمدت بر سامانه های هوشمند مستقل و واگذاری تصمیمات سرنوشت ساز به سامانه های بی مسئولیت و حکومت های فاقد مسئولیت پذیری اشاره کرد.

حجت الاسلام شهریاری گفت: همچنین باید نسبت به کاربردهای فعلی این فناوری نیز حساسیت بیشتری نشان داد. سلاح هوشمندی که در ترور شهید یحیی السنوار و شهید اسماعیل هنیه به کار رفت باید در این کنفرانس به طور جدی پیگیری شود و اقدامات رژیم صهیونیستی در این زمینه محکوم گردد. این رژیم غاصب دارای سلاح های هسته ای سلاح های هوشمند و سلاح های شیمیایی است و بر عهده مجامع فقهی است که حرمت به کارگیری این سلاح ها را تبیین نمایند.این رژیم غاصب با این کاربردها امنیت جهانی را به طور جدی به خطر می اندازد و صلح عادلانه را مخدوش می سازد و کرامت انسانی را پایمال می کند.

دبیرکل مجمع خاطرنشان کرد: بهره گیری از منابع بین المللی معتبر برای شناخت موضوع و درک ابعاد آن ضرورت است. از جمله این منابع می توان به سند IEEE درباره اخلاق هوش مصنوعی (سال ۲۰۱۹ ) گزارش یونسکو در موضوع اخلاق هوش مصنوعی (سال ۲۰۲۱ ) که استاد دکتر یاسر عجیل النشمی نیز در سخنان خود به آن اشاره کردند و قانون اتحادیه اروپا در زمینه هوش مصنوعی اشاره کرد که این منابع چارچوب هایی دقیق و قابل مقایسه برای ارزیابی آسیب ها و خطرات فراهم می کنند.

وی در پایان اتخاذ رویکرد تحلیلی و مسأله محور به جای صرفاً رویکرد خطابی و هشداردهنده را ضروری دانشت و افزود: استفاده از تعابیری همچون: «هوش مصنوعی وسیله ای برای کشتار فریب و تدلیس است» بیشتر جنبه هشداردهنده دارد تا تحلیلی. چنین زبانی ممکن است برای مخاطبان علمی یا بین المللی قانع کننده نباشد و نیازمند بازنویسی در چارچوب تحلیل های نهادی و روش مند باشد.همچنین با اینکه اشاره به مفاهیمی همچون تبعیض الگوریتمی فقدان شفافیت و ضعف مسئولیت پذیری قابل تقدیر است اما کافی نیست؛ بلکه باید به تحلیل دقیق سازوکارهای فنی پشت این آسیب ها پرداخت مانند: ساختار شبکه های عصبی یادگیری ماشین و ماهیت داده های مورد استفاده در آموزش و کلان داده ها. در نهایت تمام این موارد باید به گونه ای بررسی شود که کرامت انسانی حفظ گردد و از ماشینی شدن جامعه انسانی جلوگیری به عمل آید.

انتهای پیام